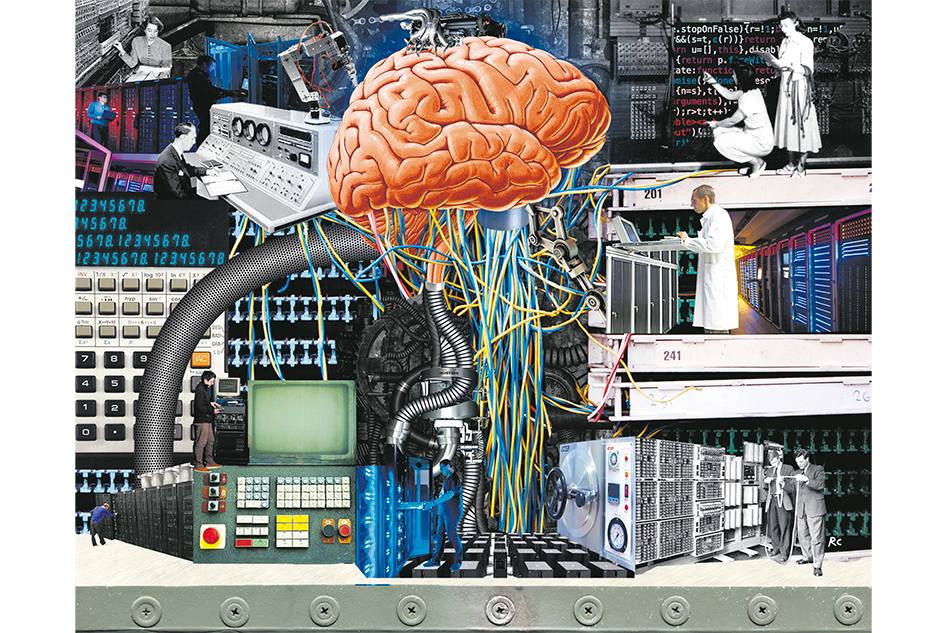

INFORME

El cerebro tecnológico de las universidades

Científicos de distintas casas de estudio resaltan la importancia de las supercomputadoras a la hora de hacer ciencia y marcan la necesidad de tener un plan estatal que acompañe su desarrollo en el país.