El cambio climático es una de las mayores preocupaciones de la comunidad internacional, y el auge del big data permitió el acceso a una colosal cantidad de datos sobre la atmósfera. Como consecuencia, el análisis y la combinación para realizar las posteriores predicciones están en constante desarrollo.

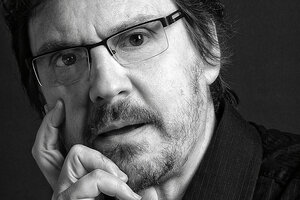

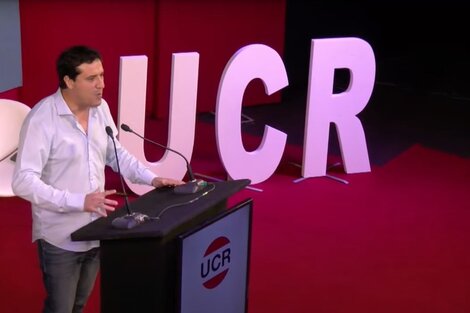

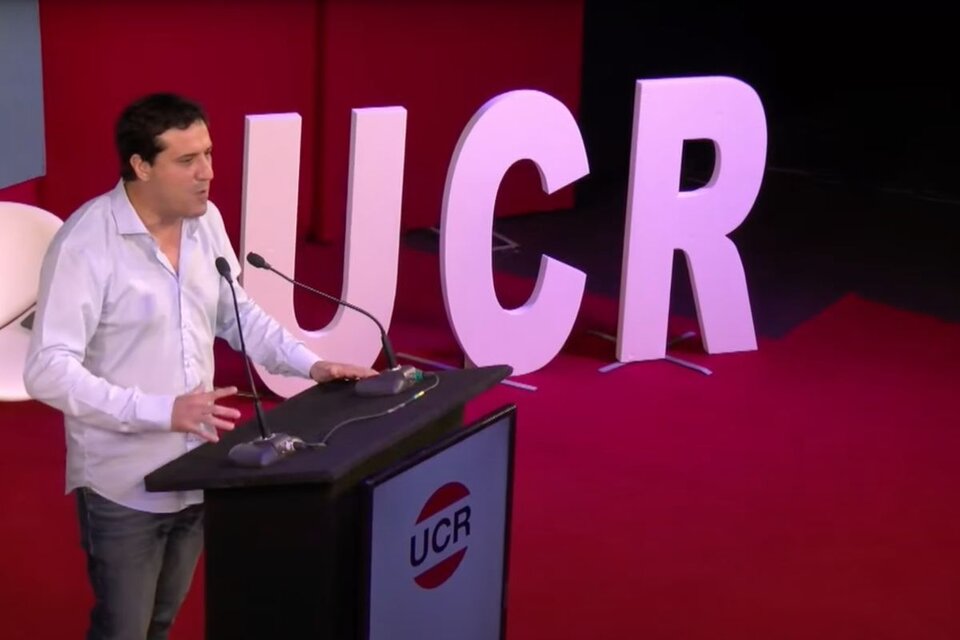

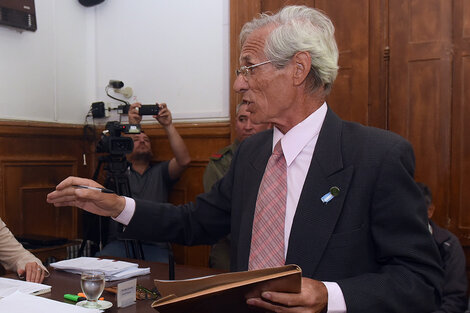

El físico Manuel Pulido es docente del Departamento de Física de la Facultad de Ciencias Exactas y Naturales y Agrimensura de la Universidad Nacional del Nordeste (UNNE) y miembro del Grupo de Investigaciones en Ciencias Atmosféricas del CONICET y lleva adelante un proyecto de asimilación de datos, que permite la optimización de esos grandes volúmenes de información.

-¿De qué se trata el proyecto?

-En las mediciones de la atmósfera el big data se da como paradigma. Existen numerosas fuentes de información y el objetivo de la asimilación de datos es, en primera instancia, la recopilación de esos datos en tiempo real. Luego, se los combina con un modelo físico que, esencialmente, son los modelos numéricos del pronóstico meteorológico. Así surge el resultado que se llama “análisis”. Es la fuente de información que se posee para realizar estudios del cambio climático. Además, para hacer el pronóstico meteorológico también se utiliza la asimilación. Al aumentar la cantidad de observaciones que tenemos, aumentan los desafíos de análisis. Nosotros estamos enfocados en nuevas técnicas que permitan mejorar la producción de esa asimilación de datos. Por ejemplo, como ahora los modelos aumentan de resolución esto hace que se incluya la conversión que tiene que ver con las tormentas y eso establece nuevos desafíos en la asimilación de datos. Necesitamos cuantificar el error o incertezas que tiene cada una de estas fuentes de información y tratar de obtener un resultado que reduzca las incertezas.

-¿Qué cambios se produjeron en las formas de estudio con el big data?

-Lo que se hacía antes era trabajar con optimización, es decir trabajar con una muestra que tuviera el menor error posible. Ese paradigma ha cambiado. Ahora se trabaja con un ensamble, que tiene muchas posibilidades. No sólo contás con el más fuerte, sino que tenés un conjunto de individuos y conservás la diversidad. Eso te ayuda, por un lado, para la incerteza y, por otro, para determinar eventos extremos, que son muy difíciles de predecir. Sin embargo, al trabajar con todos esos individuos, en el caso de que aparezca un evento extremo, podemos catalogarlo. Esto hace mucho más posible predecirlos. Se trabajan con varios individuos y se les agrega diversidad.

-¿De qué forma?

-Siempre se trabaja en entornos con algo de aleatorio. Son procesos estocásticos normales y asumimos que existen porque nunca vamos a conocer la situación exacta de la atmósfera. Hay una parte que sí conocés y otra aleatoria. La otra parte de la diversidad te la da la asimilación de datos en sí, porque la incerteza se va catalogando; entonces, el mismo estudio te va dando la idea de cuán incierto es el sistema en determinado tiempo.

-Es decir que se reduce la incerteza…

-No se trata de disminuir la incerteza, se trata de estimar la incerteza real del sistema. Nosotros sabemos que desconocemos muchos aspectos de las observaciones y del modelo, entonces lo que tenemos que hacer es cuantificarlas, porque eso nos está dando lugar a realizar predicciones: qué otros estados posibles hay y con cuánta certeza la obtuvimos.

-¿Dónde se aplica?

-Las aplicaciones son para el cambio climático, porque se hacen proyecciones a 30 o 40 años, y ese dato es utilizado para ver tendencias. Y por otro lado para realizar pronósticos. Por ejemplo, si se quiere realizar pronósticos de tormentas hace falta una asimilación de datos de muy alta resolución y a muy corto plazo.

-¿Qué avances se consiguieron?

-El aprendizaje automatizado ha mejorado y cada vez estamos más cerca de analizar grandes volúmenes de forma automática. Es un área que ha crecido un montón en los últimos años y eso ha hecho que muchísimas aplicaciones sean posibles.

-¿Tiene plazos estipulados?

-A corto plazo en la línea que fue financiada un poco por la Agencia Nacional de Promoción Científica y Tecnológica y otro poco por el European Research Council. Y a largo plazo, el Servicio Meteorológico tiene una línea estratégica para desarrollar esta asimilación de datos para utilizarlo en el pronóstico. Actualmente, está usando la asimilación de datos que se realiza en centros internacionales.

-¿Los recortes en ciencia afectaron la investigación?

-El desfinanciamiento no ha afectado esta investigación en particular. Sí la devaluación, porque los fondos son en pesos y se nota a la hora de comprar. Además, es limitada la cantidad de recursos que tenemos, tanto para el almacenamiento como para el procesamiento de los datos.

-Algunos mandatarios, como Trump y Bolsonaro, niegan el cambio climático. ¿Qué análisis hace de esta tendencia?

-Se están aislando de la sociedad del conocimiento, que lleva 20 o 30 años trabajando con el cambio climático y sacando resultado con las cosas que le están sucediendo al planeta. Uno se concentra en resultados científicos para estudiar qué tan importante es o qué efectos trae, mientras que ellos lo niegan por una “cuestión de fe”.